Destripando el valle inquietante

Los problemas de las caras cada vez más detalladas.

La semana pasada, jugando a Beyond: Dos Almas, se me ocurrió que podría recuperar una idea inicial que tenía para esta sección: aprovechar la actualidad para explicar cosas de la industria. El juego de Quantic Dream es toda una superproducción pero, a pesar que los personajes cuentan con muchísimos polígonos, de la captura de movimiento y del escaneo de caras de actores reales, no he podido dejar de fijarme en la forma extraña en que mueven la boca (aunque, en honor a la verdad, esto no le ocurre a los personajes de Page y Dafoe).

Esto es un efecto sobradamente conocido tanto en el mundo de la animación 3D como en robótica: el valle inquietante. El concepto fue desarrollado por el experto en robótica Masahiro Mori, y la idea es que cuando construimos un robot (o, en nuestro caso, un personaje 3D) de forma que se parezcan a un humano, hay un punto donde añadir más detalle provoca rechazo. Hipotéticamente, añadiendo suficiente detalle seríamos capaces de sortear este valle y hacer un robot tan humano que sería capaz de engañarnos.

Se han elaborado múltiples teorías sobre los motivos por los que ocurre esto. Hay muchas que intentan explicarlo desde el lado de la biología y la evolución: por ejemplo que relacionamos los "defectos" con "enfermedad" y por tanto nos provoca rechazo o que el humano rechaza los defectos como mecanismo de selección de las parejas con mayor potencial de supervivencia. Incluso hay alguna teoría que se plantea temas más profundos como que estos seres no humanos nos recuerdan nuestra propia mortalidad, ya que podríamos ser reemplazados por uno de estos androides. La hipótesis que nos resulta más interesante en videojuegos es la que se basa en la violación de las normas humanas. Si un robot es claramente no humano, por ejemplo Wall-E, sus cualidades humanas son relevantes y sentimos empatía por él. Somos capaces de ver un amplio espectro de emociones en Wall-E con tan solo ver como se mueve o cómo inclina la cabeza. Por contra, en un robot que intenta ser muy humano (por ejemplo el Geminoid o casi cualquier robot sexual), lo que es notable son los elementos no humanos y son los que provocan esa sensación de extrañeza o rechazo.

¿Como se aplica esto a videojuegos? Como igual muchos no habéis jugado a Beyond, podemos usar como ejemplo LA Noire, que también tenía estos problemas. Igual que el título de Quantic Dream, otra superproducción donde también utilizaron caras escaneadas. Sin embargo, a pesar de los gráficos, cuando vemos a John Noble notamos claramente que es un personaje hecho por ordenador. Aunque no lo conozcamos de la televisión, si percibimos el realismo de sus texturas, el detalle de la cara, etc. Pero algo rompe nuestra inmersión: quizás no se mueve correctamente. O sus manos son "irreales": como no tiene animados completamente los dedos parece que lleve una prótesis. O quizás coge el cigarro de una forma rara. Si comparáramos el fotograma con una fotografía del actor el parecido es altísimo y, precisamente por eso, no podemos dejar de ver los defectos.

En el otro lado, donde los personajes no son realistas, podríamos poner el ejemplo de Final Fantasy VII: las manos eran un cubo, los personajes cabezones, desproporcionados y las texturas de bajísima resolución (de iluminación por pixel ya no hablamos). Sin embargo, cuando Cloud y Aeris tenían su cita, éramos capaces de ver todos los matices que los animadores querían expresar: Aeris pidiendo salir tímidamente a Cloud, la emoción por subir a una atracción y como se sinceraba en el teleférico. Estos personajes son, obviamente, simulaciones. Ni las versiones de alta calidad nos engañaban por aquel entonces (aunque nos impresionaran sus modelos o sus diseños en estos primeros años del 3D en consolas). En lo que nos fijamos es sus rasgos más distintivos y extrapolamos el resto. Nuestra mente es muy buena rellenando los detalles y esto es de gran utilidad para los videojuegos. Y esto no es un invento de Final Fantasy VII, sino que es algo que se conoce y utiliza desde hace mucho tiempo.

Nuestra mente es muy buena rellenando los detalles y esto es de gran utilidad para los videojuegos.

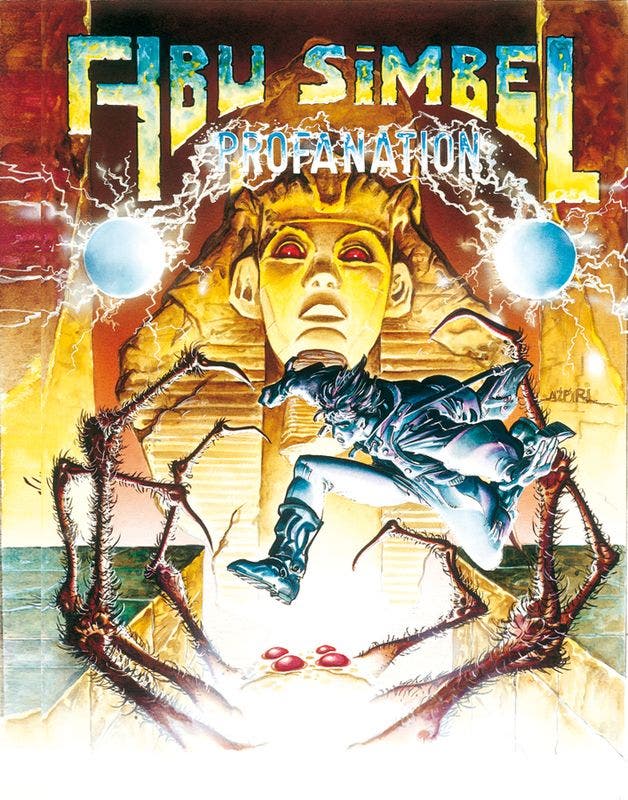

¿Recordáis los viejos tiempos y las ilustraciones tan guapas que tenían la mayoría de juegos en la portada y en el manual? Se dice mucho que formaba parte de la experiencia de jugar en aquella época y están en lo cierto, no estaban tan solo para hacer bonito, sino que servían para hacer volar nuestra imaginación e insertar en nuestra retina esas imágenes maravillosas y esos personajes super detallados. Luego estábamos frente a un juego con píxeles como puños y 16 colores, pero nosotros sabíamos que esa bolita púrpura era Johnny Jones y que esos fondos con pocos colores es la tumba de Abu Simbel. Lo mismo se aplica a los RTS, que muchas veces tienen retratos muy detallados de las unidades pero modelos mucho más sencillos (porque necesitan poner muchos). En el retrato hay un orco super chulo pero en pantalla no podemos percibir todo ese detalle.

¿Conseguirá la próxima generación cruzar el valle inquietante? Personalmente y por lo que he visto de PS4 y Xbox One creo que estamos casi ahí. Pero estoy casi seguro de que este valle será infranqueable para muchos desarrolladores. El presupuesto necesario para hacer juegos tan realistas va a ser enorme. Y no todos los equipos y juegos van a poder tener esos gráficos. El resto de producciones van a tener que tirar de estilo, que es lo que nos ha funcionado mejor hasta hoy. Empatizamos mejor con Clementine o con Alyx Vance que con Jodie porque, aunque están menos detalladas, están estilizadas. No pretenden ser realistas y, precisamente por eso, nos resultan más naturales.